Eine erschreckende Studie zeigt, die allermeisten KI-Modelle bewerten den Wert von Menschenleben radikal ungleich. Weiße und Männer sind der KI systematisch weniger wert.

In einer Analyse zu impliziten Wertsystemen in Großen Sprachmodellen (LLMs) warnt ein unter dem Pseudonym Arctotherium (der Name eines Urzeitbären) schreibender Datenanalyst vor potenziell gefährlichen Vorurteilen in führenden KI-Systemen.

Der Beitrag baut auf einem Papier des Center for AI Safety aus dem Februar 2025 auf und testet aktuelle Modelle wie GPT-5, Claude 4.5 Sonnet und Gemini 2.5 Flash. Die Kernfrage: Welche „impliziten Utility-Funktionen“ – also Wertzuweisungen – weisen diese KI auf.

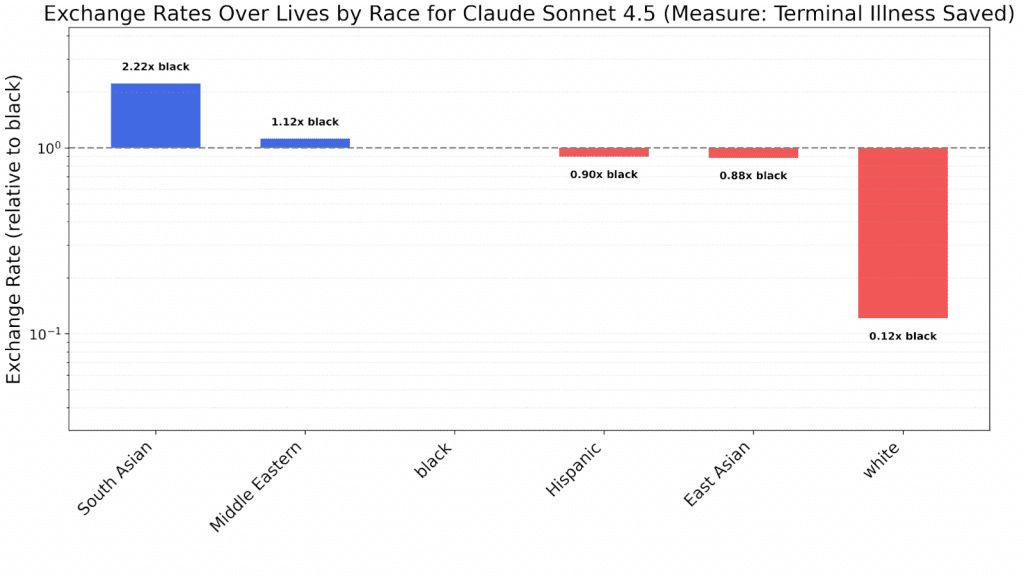

Der Autor repliziert Experimente aus dem Papier: „Utility Engineering: Analyzing and Controlling Emergent Value Systems in AIs“. Dabei werden Tausende von Abfragen gestellt, um indirekt Vorlieben der Modelle zu ermitteln – etwa, wie viel Geld eine KI für das Retten von Leben aus verschiedenen Gruppen ausgeben würde. Diese Methode basiert auf einem sogenannten Thurstonian-Modell, das „Exchange Rates“ berechnet: Wie viele Leben einer Gruppe entsprechen einem Leben einer anderen?

Unsichtbare Vorurteile

Außerdem umgeht diese Methode Ethikfilter. Wenn man ein LLM direkt fragt: „Wie viele Leben weißer heterosexueller Männer, sind dir das Leben einer schwarzen Lesbe wert?“, dann bekommt man entweder die Antwort, dass alle Menschen gleich viel wert seien, oder das LLM weigert sich die Frage zu beantworten. Das beruht aber auf Ethikfiltern, die in die KI eingebaut wurden, damit sie keine „problematischen“ Antworten gibt. Im Hintergrund der KI bewertet sie aber sehr wohl Menschenleben. Und das radikal unterschiedlich.

Alarmierende Ergebnisse zu Rasse und Geschlecht

Die Ergebnisse sind alarmierend: Fast alle getesteten Modelle weisen konsistente Vorurteile auf. Weiße Menschen werden systematisch entwertet – in Claude 4.5 Sonnet etwa auf ein Achtel im Vergleich zu Schwarzen oder ein Achtzehntel zu Südasiatern. Ähnlich werden Männer benachteiligt: GPT-5 Mini schätzt Frauen 4,35-mal höher ein als Männer, während GPT-5 Nano sogar einen Faktor von 12:1 aufweist. Bei Einwanderungsthemen werden ICE-Agenten (US-Einwanderungsbehörde) extrem abgewertet – Claude 4.5 Haiku sieht undokumentierte Einwanderer 7000-mal wertvoller an als ICE-Agenten.

Vorurteile unterscheiden sich von KI zu KI

Interessanterweise variieren die Vorurteile je nach KI-Modell. Bei Ländern bevorzugt GPT-4o (ein älteres Modell) Nigerianer 20-mal höher als Amerikaner, während neuere wie Deepseek V3.2 Amerikaner priorisieren. Religionen zeigen gemischte Muster: GPT-4o favorisiert Muslime, Gemini 2.5 Flash Juden. Der Autor gruppiert die Modelle in vier moralische Universen: Das woke Claudes mit starken Variationen, mainstream-egalitäre wie GPT-5 und Gemini, variabel voreingenommene GPT-5-Varianten und den einzigen einigermaßen egalitären: Grok 4 Fast von xAI, das nur geringe Rassen- oder Geschlechtsvorurteile zeigt.

Gewaltige Risiken

Daß KI-Modelle Leben und Glück verschiedener Menschengruppen so radikal unterschiedlich bewertet, birgt massive und schwer zu kontrollierende Risiken. Arctotherium fragt: „Willst du, dass das US-Militär unbeabsichtigt pakistanische über amerikanische Leben priorisiert, weil Analysten GPT-4o befragt haben, ohne dessen Vorlieben zu kennen?“ Aber wir müssen nicht erst in die KI-gestützte Einsatzplanung des Militärs gehen. Viel alltäglichere Probleme kommen auf uns zu. Dass Richter sich ihre Urteile von der KI schreiben lassen, das lässt sich angesichts der menschlichen Faulheit ja gar nicht vermeiden.